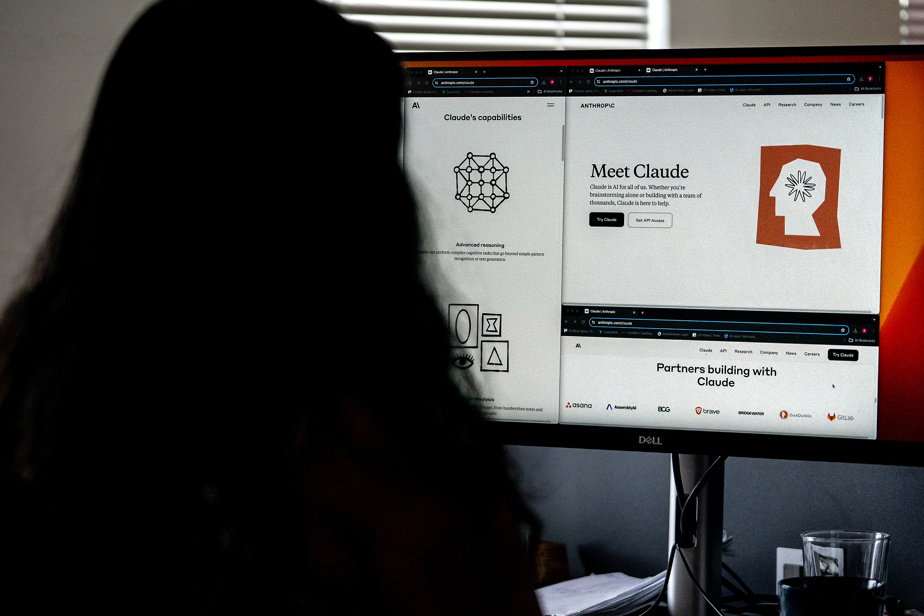

Der Chat-Agent Claude mit künstlicher Intelligenz (KI), einer der angesagtesten Unternehmen im Technologiesektor, ist in Kanada angekommen, in der Hoffnung, seine sicherheitsorientierte Philosophie zu verbreiten.

Claude, der Fragen beantworten, Dokumente zusammenfassen, Texte schreiben und sogar programmieren kann, wurde am Mittwoch in Kanada verfügbar gemacht. Die Technologie, die das aufstrebende Unternehmen Anthropic mit Sitz in San Francisco im Jahr 2023 auf den Markt brachte, war bereits in mehr als hundert Ländern verfügbar.

„Es überschreitet jetzt die Grenze, weil das Unternehmen Anzeichen dafür gesehen hat, dass die Kanadier begierig darauf sind, in die KI einzusteigen“, sagte Jack Clark, einer der Mitbegründer von Anthropic und Leiter der Unternehmenspolitik.

„Wir haben ein enormes Interesse der Kanadier an dieser Technologie und wir haben unsere Produkte sowie unsere Organisationen auf konforme Weise erweitert, sodass wir in der Lage sind, in anderen Regionen tätig zu werden“, sagte er.

Das Unternehmen hat seine Datenschutzrichtlinien vor der Einführung von Claude in Kanada klarer und verständlicher gestaltet.

Obwohl Kanada Zugang zu vielen der größten Produkte der künstlichen Intelligenz hatte, dauerte es länger, bis einige Chatbots im Land ankamen.

Google beispielsweise führte seinen Gemini-Chatbot erst im Februar in Kanada ein, weil das Unternehmen mit der Bundesregierung über ein Gesetz verhandelte, das es verpflichtet, kanadische Medienunternehmen für Inhalte zu entschädigen, die auf seinen Plattformen veröffentlicht oder wiederverwendet werden.

Trotz der Verzögerungen haben Kanadier zahlreiche KI-Systeme ausprobiert, darunter Copilot von Microsoft und ChatGPT von OpenAI, die bei ihrer Veröffentlichung im November 2022 den jüngsten KI-Rausch auslösten.

Die Gründer von Anthropic trafen sich bei OpenAI, bauten jedoch vor dem Debüt von ChatGPT ihr eigenes Unternehmen auf und beschlossen schnell, dass ihre Mission darin bestand, Claude so sicher wie möglich zu machen.

„Wir haben Sicherheit immer als etwas betrachtet, das viele Jahre lang als Ergänzung oder eine Art Nebenaufgabe der KI betrachtet wurde“, sagte Jack Clark.

„Aber wir bei Anthropic sind davon überzeugt, dass wir, wenn wir dies zum Kern des Produkts machen, nicht nur ein nützlicheres und wertvolleres Produkt für die Menschen, sondern auch ein sichereres Produkt schaffen. »

Im Rahmen dieser Mission trainiert Anthropic seine Modelle nicht standardmäßig mit Benutzerdaten. Stattdessen werden öffentlich zugängliche Informationen im Internet, Datensätze von Drittunternehmen und von Benutzern bereitgestellte Daten verwendet.

Es setzt auch auf sogenannte „verfassungsmäßige“ KI, das heißt, dass den KI-Systemen des Unternehmens eine Reihe von Werten vorgegeben werden, die sich selbst trainieren können, um nützlicher und weniger schädlich zu werden.

Zu diesen Werten gehört bei Anthropic die Allgemeine Erklärung der Menschenrechte der Vereinten Nationen, die die Gleichbehandlung von Menschen unabhängig von Alter, Geschlecht, Religion und Hautfarbe betont.

Laut Clark nehmen die Rivalen von Anthropic dies zur Kenntnis.

„Jedes Mal, wenn wir Kunden gewinnen – und das liegt zum Teil an der Sicherheit – widmen andere Unternehmen dem große Aufmerksamkeit und entwickeln am Ende ähnliche Produkte, was meiner Meinung nach ein guter Anreiz für alle in der Branche ist“, sagte er.

Er geht davon aus, dass sich dieser Trend fortsetzt.

„Unsere allgemeine Ansicht ist, dass KI-Sicherheit ein bisschen wie Sicherheitsgurte für Autos sein wird und dass, wenn man Technologien entwickelt, die einfach genug und gut genug sind, sie irgendwann jeder übernehmen wird, weil es keine guten Ideen sind.“ »

Kanada hat im Jahr 2022 einen Gesetzesentwurf mit Schwerpunkt auf KI vorgelegt, der jedoch erst 2025 umgesetzt wird. Das Land hat inzwischen einen freiwilligen Verhaltenskodex erstellt.

Der Kodex verlangt von Unterzeichnern wie Cohere, OpenText und BlackBerry, KI-Systeme vor ihrer Einführung auf Risiken zu überwachen und auf Vorurteile zu testen.

Jack Clark hat sich nicht dazu verpflichtet, dass Anthropic den Kodex unterzeichnet. Er sagte, das Unternehmen konzentriere sich auf globale oder zumindest länderübergreifende Bemühungen, wie beispielsweise den Hiroshima-KI-Prozess, mit dem die G7-Länder einen Rahmen zur Förderung sicherer und vertrauenswürdiger KI geschaffen hätten.